Jednym z kluczowych, chociaż ubocznych skutków rozwoju AI jest znaczący wzrost zapotrzebowania na centra przetwarzania danych, a co za tym idzie energię potrzebną do ich zasilania. Istnieje spore ryzyko, iż wzrost zużycia prądu będzie tak duży, iż znacząco odciśnie się na całym systemie energetycznym i istotnie wpłynie na ceny energii. Dlatego Google przedstawił dane, które rzucają światło na całe zagadnienie.

W liczbach bezwzględnych wygląda to bardzo poważnie. Google ujawnił bowiem dramatyczny wzrost zużycia energii przez swoje centra danych – z 14,4 milionów MWh w 2020 roku do 30,8 milionów MWh w 2024 roku. To oznacza ponad dwukrotny wzrost w ciągu zaledwie czterech lat. Centra danych stanowią w tej chwili 95,8 proc. całkowitego budżetu energetycznego firmy. W liczbach cząstkowych jest już jednak nieco inaczej. Jedna interakcja, określona jako wyświetlenie komunikatu tekstowego w systemie Gemini średnio pochłania 0,24 Wh energii, tyle samo co oglądanie telewizji przez dziewięć sekund. Innym choćby bardziej działającym na wyobraźnię porównaniem jest jedna sekunda pracy kuchenki mikrofalowej. Biorąc pod uwagę, iż np. podgrzewanie lunchu w biurze trwa około 2 – 3 minut daje to odpowiednik około 150 zapytań i odpowiedzi udzielonych przez AI.

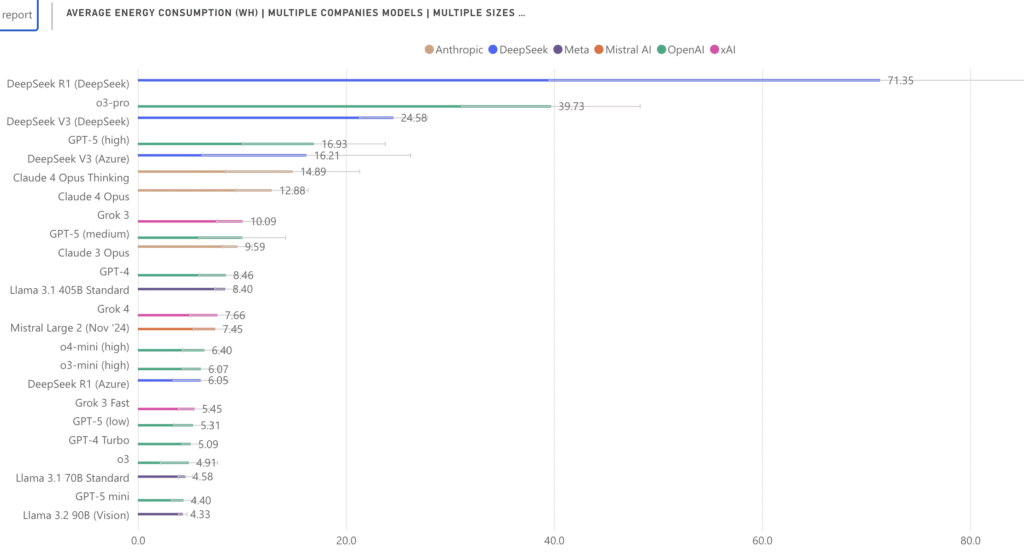

Analiza Google pokazuje, iż same chipy AI (TPU) odpowiadają tylko za niewielką część całkowitego zużycia energii. CPU i pamięć maszyny gospodarza zużywają dodatkowe 25 proc. całkowitej energii, systemy zapasowe 10 proc., a pozostałe 8 proc. to koszty ogólne centrum danych, takie jak chłodzenie. Jest to pierwsza tak szczegółowa informacja od dużej firmy technologicznej. Mocno odbiega jednak o szacunków opartych na testach przeprowadzonych niedawno przez laboratorium sztucznej inteligencji Uniwersytetu Rhode Island. Gemini nie była brana w nich pod uwagę, niemniej w przypadku Chata GPT-5 średnio było to 10,05 Wh. Więcej niż w przypadku Groka 4 (7,66 Wh) i mniej niż w przypadku Clauda 4 (12,88 Wh). Sztuczna inteligencja stworzona przez Open AI mieści się więc gdzieś po środku, ale co najważniejsze kalkulacje uczelnianego laboratorium są 40 razy wyższe niż te przedstawione przez Google.

Rozbieżność są tak ogromna, iż można mieć wątpliwości, czy w obu badania przyjęły tę samą metodologię zliczania poboru mocy lub tę samą definicję średniego zużycia związanego z zapytaniem. W tym względzie istotna jest informacja Google, na temat znaczące poprawy wydajność pracy AI. Według koncerny ciągu 12 miesięcy mediana zużycia jej w przeliczeniu na komunikat Gemini spadła o 97 proc. Google przypisuje te zyski postępom w architekturze modelu językowego, bardziej wydajnym algorytmom, specjalnie zaprojektowanemu sprzętowi i szerszym optymalizaciom ogólnosystemowym. Trend ten szedłby jednak całkowicie pod prąd tego co naukowcy z Uniwersytetu Rhode Island ustalili dla Chata GPT – jego najnowsza wersja 5 jest 8,6 razy bardziej energochłonna niż poprzednia numer 4.

/Fot: Chris Weiher via Unsplash//

4 miesięcy temu

4 miesięcy temu

![Przez osiem lat społecznie zebrał tony śmieci, ale tym razem złapał się za głowę. „A co będzie, jak Vivaldiego zabraknie?” [FOTO]](https://swidnica24.pl/wp-content/uploads/2026/02/Waldemar-Wozniak-sprzata-2026.02-87.jpg)