Nowy konsultowany właśnie przez KE akt UE – akt o przejrzystości cyfrowej (DFA) – zakłada szeroką ochronę konsumentów w świecie cyfrowym. Pojawiają się jednak zasadnicze pytania o realność tych obietnic.

Komisja Europejska zamierza wdrożyć Digital Fairness Act (brak oficjalnie ustanowionego polskiego tłumaczenia nazwy) – akt, który ma wypełnić luki w unijnym systemie ochrony konsumentów funkcjonujących w świecie usług cyfrowych.

Choć jego zapowiadany zasięg obejmuje niemal wszystkie sektory internetowe – od platform e-commerce po gry online – zakres regulacji i ambicje twórców budzą więcej pytań niż entuzjazmu.

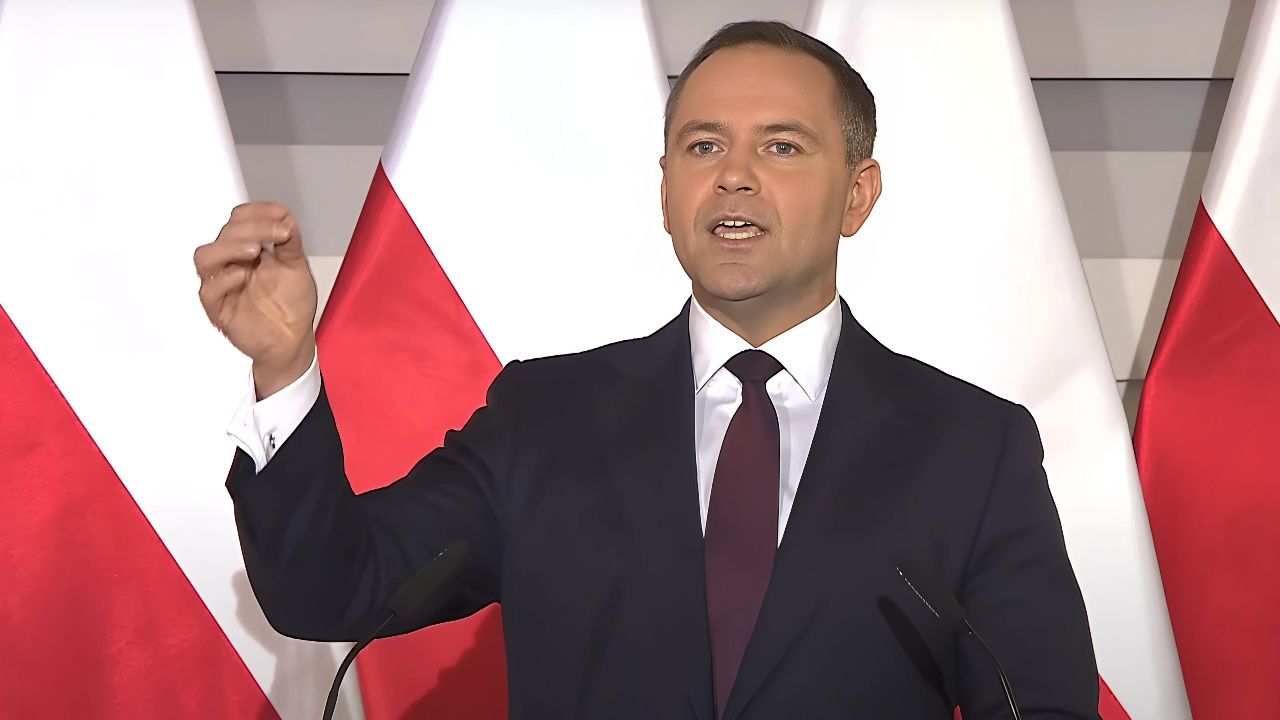

Komisarz ds. sprawiedliwości i konsumentów Michael McGrath wskazuje m.in. na praktyki projektowania uzależniających interfejsów, nieuczciwe personalizacje czy sztuczki związane z subskrypcjami. Problem w tym, iż regulacja ma dotyczyć „wszystkiego” – co sprawia, iż może nie dotknąć skutecznie niczego.

DFA ma być narzędziem zwalczania tzw. „ciemnych wzorców” – interfejsów internetowych zaprojektowanych w sposób mający na celu manipulację użytkownikiem. Intencje są zrozumiałe, ale ich realizacja pozostaje mglista.

Praktyki takie jak automatyczne konwersje okresów próbnych na płatne subskrypcje, niechciane przedłużenia czy skomplikowane procedury anulowania usług są rzeczywiście plagą współczesnych usług cyfrowych. Bez konkretnego mechanizmu egzekucji i sankcji trudno jednak traktować nową propozycję jako przełom.

Inflacja regulacyjna czy realna reforma?

Uproszczenie i konsolidacja przepisów to kolejny postulat Komisji. McGrath sugeruje, iż DFA będzie „kluczowym elementem” zmniejszającym obciążenia administracyjne. Tymczasem inna decyzja tej samej Komisji – wycofanie wniosku ustawodawczego dotyczącego odpowiedzialności za sztuczną inteligencję – stoi z tą deklaracją w sprzeczności.

Z jednej strony planuje się przeciwdziałanie nadużyciom systemów cyfrowych, z drugiej rezygnuje się z ustanowienia ram prawnych, które określałyby, kto ponosi odpowiedzialność w przypadku szkód wyrządzonych przez AI.

Z raportu przygotowanego na zlecenie Parlamentu Europejskiego jasno wynika, iż porzucenie projektu aktu o odpowiedzialności za AI prowadzi do fragmentacji regulacyjnej. Już teraz Niemcy i Włochy podejmują własne inicjatywy w tym zakresie – co grozi rozbiciem jednolitego rynku cyfrowego UE i mnożeniem przepisów, które wzajemnie się wykluczają.

Andrea Bertolini, autor analizy i profesor prawa na Uniwersytecie w Pizie, nie pozostawia złudzeń: tylko skuteczne unijne rozporządzenie może zapewnić harmonizację i rzeczywistą ochronę użytkowników.

Współczesna cyfrowa asymetria

Warto zadać pytanie, czy można mówić o „uczciwości” cyfrowej bez uregulowania najbardziej kontrowersyjnego aspektu dzisiejszego internetu – odpowiedzialności za działania systemów sztucznej inteligencji.

Proponowana DFA w ogóle nie odnosi się do tej kwestii, mimo iż większość praktyk uznanych za manipulacyjne (np. personalizowane sugestie zakupowe, algorytmy uzależniające użytkowników od treści czy dynamiczne ceny) opiera się właśnie na wykorzystaniu AI.

Obecnie brak jasnego mechanizmu, który umożliwiałby użytkownikom dochodzenie roszczeń w przypadku szkód wywołanych przez systemy AI – zarówno w kontekście ich działania, jak i decyzji podjętych na podstawie algorytmów.

Odrzucenie projektu aktu o odpowiedzialności za sztuczną inteligencję przez Komisję w imię „upraszczania przepisów” jest w świetle analiz Parlamentu Europejskiego nie tylko decyzją kontrowersyjną, ale także potencjalnie szkodliwą.

Tiemo Wölken, członek komisji prawnej PE, wprost stwierdził, iż pozostawienie kwestii odpowiedzialności za AI bez regulacji może generować poważne zagrożenie. Trudno nie przyznać mu racji.

Brak centralnego unijnego aktu w tej dziedzinie skazuje obywateli na nierówną ochronę – w zależności od państwa członkowskiego. Jednocześnie oddaje pole prywatnym korporacjom, które mogą kształtować zasady odpowiedzialności na własnych warunkach.

Niedookreślone dzieciństwo cyfrowe

Jednym z głównych obszarów DFA ma być ochrona małoletnich. Komisja Europejska już wcześniej opublikowała wytyczne w ramach Digital Services Act (DSA), mające przeciwdziałać zagrożeniom dla dzieci i młodzieży w sieci. Relacja między standardami, określonymi w DFA a istniejącymi regulacjami pozostaje jednak niewyjaśniona. Czy nowy akt uzupełni DSA? Czy może wprowadzi konkurencyjne standardy?

Tymczasem zagrożenia związane z aktywnością nieletnich w internecie mają charakter hybrydowy – łączą kwestie prywatności, wpływu treści na rozwój psychiczny oraz nadużyć związanych z monetyzacją uwagi.

Platformy społecznościowe, aplikacje mobilne czy gry online coraz częściej stosują algorytmy, które nie tylko śledzą zachowania użytkowników, ale i celowo kierują ich do angażujących (często szkodliwych) treści.

Bez regulacji, które obejmowałyby nie tylko zachowania platform, ale i zasady odpowiedzialności za działanie algorytmów, wszelkie deklaracje ochrony pozostają fasadowe.

Uczciwość bez sprawiedliwości?

Digital Fairness Act jawi się jako projekt, który może poruszyć wiele problemów, ale nie gwarantuje ich rozwiązania. W praktyce to katalog słusznych postulatów – walka z nieuczciwą personalizacją, uproszczenie procedur anulowania usług, kontrola praktyk influencerów – który może ograniczyć się do deklaracji.

Bez instrumentów egzekucyjnych i powiązania z realnym mechanizmem odpowiedzialności za AI, akt ten może okazać się kolejnym przykładem unijnej „regulacji-widma”.

Fundamentalne pytanie brzmi więc: jak można mówić o uczciwości cyfrowej bez zapewnienia sprawiedliwości prawnej? jeżeli za szkodę wywołaną przez działanie systemu AI nie odpowiada ani jego twórca, ani dostawca, to wobec kogo użytkownik może dochodzić roszczeń?

Skoro nie wiadomo, jak DFA wpisze się w istniejący krajobraz regulacyjny (DSA, AI Act, RODO), czy nie pogłębi istniejącej niespójności?

Nie można też pominąć aspektu legitymacji – decyzja o wycofaniu projektu aktu o odpowiedzialności za AI została podjęta przez Komisję bez szerszej konsultacji z Parlamentem Europejskim. To krok wstecz, podważający zasady równowagi instytucjonalnej UE.

I choć Komisja tłumaczy ten ruch dążeniem do „upraszczania przepisów”, coraz więcej głosów, również w PE, wskazuje, iż upraszczanie kosztem ochrony użytkowników może przynieść skutek odwrotny do zamierzonego.

3 miesięcy temu

3 miesięcy temu